SB Intuitions、独自の日本語LLMを構築

アカデミアや産業界の研究開発に資するために70億、130億、650億パラメータの日本語LLMを公開

2024年6月14日

SB Intuitions株式会社

SB Intuitions株式会社(本社:東京都港区、代表取締役社長 兼 CEO 丹波 廣寅、以下「SB Intuitions」)は、この度70億、130億、650億パラメータの日本語大規模言語モデル(Large Language Model:LLM)を公開しましたのでお知らせします。なお、SB Intuitionsは2024年度中に3,900億パラメータのLLM構築を目指しています。

公開モデル

- Sarashina1-7B

- Sarashina2-7B

- Sarashina1-13B

- Sarashina2-13B

- Sarashina1-65B

- Sarashina2-70B※

Sarashina2は、Sarashina1の開発で得られた知見を元にブラッシュアップしたモデルです。下の性能評価結果に示しますがSarashina1から大きく性能が向上したものとなっています。アカデミアや産業界でのさまざまな分析を通じ、LLMの研究開発が促進されるよう、条件の異なるSarashina1とSarashina2を同時に公開しました。なお条件の違いについては、後日SB Intuitionsのテックブログ(https://www.sbintuitions.co.jp/blog/)で紹介予定です。

注:今回公開したモデルは、指示チューニングを施していない事前学習モデルです。

人間の意図に沿った出力を行うようにチューニングを行ったものではないため、そのまま実用的なサービスに供することは想定していません。

モデル公開先のURL

https://huggingface.co/sbintuitions

※ 2024年8月7日に、Sarashina2-70Bを公開しました。(2024年8月7日に追加)

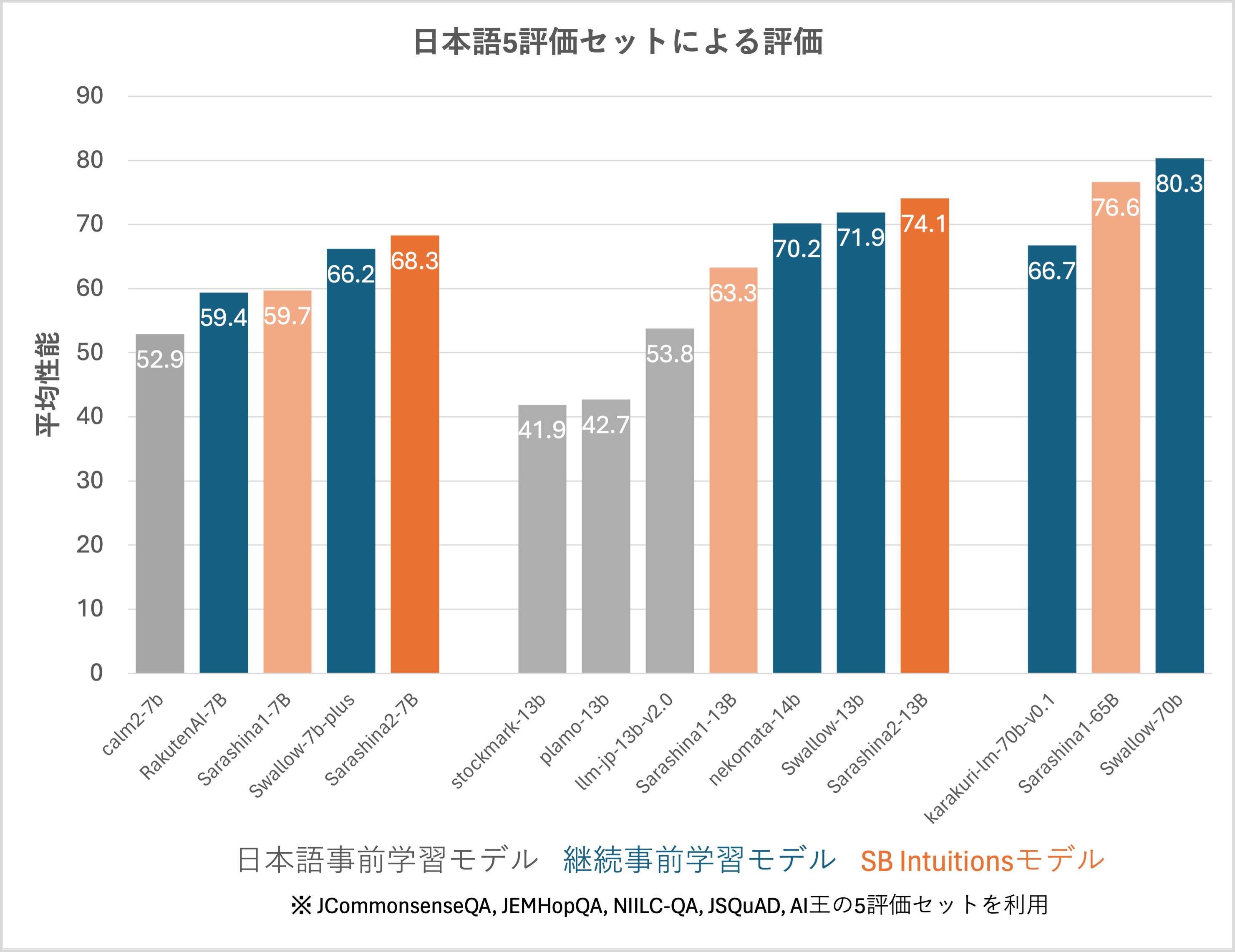

性能評価結果

日本語評価で標準的に用いられている5つの評価セットで評価したところ(注1)、Sarashina2は同程度のパラメータ数のモデルとの比較において、フルスクラッチで学習された日本語事前学習モデル、および、性能が高いことが示されている継続事前学習モデル(注2)よりもさらに高い性能を示しています。現在、Sarashina2-70Bの学習を進めています。

(注1) JCommonsenseQA(多肢選択式質問応答, [Kurihara+ 2022])、JEMHopQA(自由記述式質問応答, [石井+ 2023])、NIILC-QA(自由記述式質問応答, [関根 2003])、JSQuAD(機械読解, [Kurihara+ 2022])、AI王(自由記述式質問応答, [鈴木+ 2020])の、5つの評価セットにおける性能の平均値を算出した。

(注2)既存の事前学習モデルをベースとして、継続して事前学習を行ったモデルのことを指す。多言語で学習された事前学習モデルに日本語テキストを用いて継続学習を施したモデルも多数存在し比較的高性能であることが報告されている。

モデル名“Sarashina”の由来

SB Intuitionsは、日本語に特化した言語モデルをはじめとして日本語最高品質のマルチモーダル基盤モデルの創出を目指しています。「Sarashina」は、竹芝という地名が歴史上初めて出てくる「更級日記」に由来し、本社所在地である東京都港区の竹芝の地から、世界で活用されるモデルを発信していくという意味を込めています。

SB Intuitionsでは、今後もLLMのさらなる大規模化を進め、LLMの社会実装に向けた研究開発を推進していきます。