概要

SB Intuitionsでは、日本語や日本の文化・慣習に強い大規模視覚言語モデル(Vision-Language Model; VLM)の開発を進めており、2025年3月にオープンな日本語向けVLMであるSarashina2-Vision-8B, 14Bをリリースしました。

本記事ではVLM評価チームが行ったSarashina2-Vision-8B, 14Bの性能評価について解説します。 Sarashina2-Visionのモデル構成および学習の詳細については別記事をご参照ください。

本記事におけるSarashina2-Visionの性能評価では、以下の観点で評価を行いました。

- 日本語VLMとして、日本に関連する自然画像や図表(単一画像)の理解能力および日本語でのVQA能力を評価

- 国内外の10B前後の規模の主だったVLMとの比較

- 定性評価として、用意した画像についてのSarashina2-Vision-8B, 14Bの生成結果の観察

本記事でのVLM評価の方針

大規模視覚言語モデル(VLM)は汎用的な用途に活用でき、昨今様々な観点でその能力を評価するために多種多様なベンチマークが構築されています。 日本語VLMベンチマークの構築も徐々に進んでおり、産学界の研究者や開発者の方々の多大な貢献によって、Heron-BenchやJMMMUなどが構築され、日本語でVLMを評価するための下地が整い始めています。我々のVLM開発も、これらの先人の方々の貢献に大いに助けられています。

一方で、継続的な評価の改善に向けて評価観点の見直しやベンチマークのさらなる多様化など、議論を続ける必要があります。 ベンチマークの改善は、世界的にも議論が続けられています。例えば、代表的なVLMベンチマークであるMMMUでは、「画像を見なくても回答可能なサンプルが含まれている」という問題が指摘されました。その後、この問題を改善するため、画像を見て回答する必要があるサンプルのみで構成されるMMMU-proが提案されました。

本記事でも、日本語VLMベンチマークについて、評価方法の改善を試みました。例えば、JMMMUでは、選択肢の記号であるA, B, C, Dのような記号をパターンマッチングによりVLMの回答から抽出し、記号を抽出できない回答があった場合、選択肢の記号の中から一つをランダムに選ぶという手続きが取られます。しかしながら、パターンマッチできないような回答を出力したVLMには指示追従能力の観点で問題があると言え、ランダム選択を採用した場合はその問題がわかりづらくなってしまいます。実際、我々の過去のテックブログ記事(多肢選択形式のVLMベンチマーク)では、主要なVLMをMMMU-proで評価した結果多くのVLMでランダム選択が生じており、スコアが確率的に変化することを確認しました。このような要素は排除する、もしくはパターンマッチした場合としない場合による不正解を分けて評価する方が、VLMの能力をより正確に測ることができると考えられます。

別の観点として、日本語VLMベンチマークはまだ数自体が少ないという課題があります。JMMMUは多様な分野の画像をカバーしている点が魅力的ですが、ダイアグラムなどの模式図を含む図表は特定のカテゴリの一部に存在するのみで、画像としての多様性が限られています。 特に、図表データはテキストを含むためVLMの日本語の読み取りと理解の能力を測るという観点において重要になります。 そこでSB Intuitionsでは、日本語を含む模式図のような複雑な図表から構成される日本語VLMベンチマーク(複雑図表ベンチマーク)を構築しました。本記事でも、この複雑図表ベンチマークによる評価結果を示します。

比較対象のVLM

国内で開発されたVLMや日本語を生成可能な海外のオープンVLMの中から主に10B前後の規模のVLMと比較を行いました。

使用したVLMベンチマーク

日本語VLMのベンチマークは現状それほど多くありません。本記事の評価では、代表的なベンチマークであるJMMMUや図表に特化したJDocQAなどの既存のベンチマーク、独自に構築した複雑図表ベンチマークによって評価を行い、自然画像や図表に対する日本語VLMとしての性能を評価しました。

- JMMMU:学術的なドメインの多様な画像、多肢選択回答形式と、少量の自由記述回答形式

- Heron-Bench:自然画像やアニメ画像、自由記述回答形式

- JDocQA:官公庁の公開資料などの、図表を含むPDF画像、多肢選択回答形式と自由記述回答形式

- 複雑図表ベンチマーク:独自に作成した日本語を含む模式図などの図表画像、自由記述回答形式

ベンチマークごとの具体的な評価方法について

💡 既存のVLMベンチマークが提供している評価方法と異なる点については(★)マークを記載しました。

JMMMU1

提供元:https://huggingface.co/datasets/JMMMU/JMMMU

JMMMUは、主に学術的なドメインの画像から構成されるMMMUベンチマークを日本語訳し、さらに日本文化に関する3カテゴリ(Japanese_{Art, Heritage, History})を追加したベンチマークです。 本記事では、ベンチマーク全体に対する評価の他、日本の文化に関するカテゴリごとに評価を行いました。

本記事の評価では、以下の点で変更を加えました。

- (★)画像の中に含まれる複数画像サンプルを除外して単一画像のみに対して評価しました。全1,320件のうち1,286件での評価になります。比較対象のVLMにおいて複数枚画像に対応していないVLMが不当に不利にならないようにするためです。

- (★)VLM回答に対してJMMMUのパターンマッチで回答が抽出できない場合は不正解としました。

- (★)Qwen2-VLでは短辺が28ピクセル未満の画像は推論できない問題があったため、そのようなサンプルに対して短辺が30ピクセルとなるようにバイリニア補間で縦横サイズ比を保持しながら画像をリサイズしました。

Heron-Bench2

提供元:https://github.com/turingmotors/heron, 画像データ

日本に関連する自然画像やアニメ、水墨画などの画像で構成された自由記述回答形式のベンチマークです。単一画像は21枚で、各画像に4つまたは5つのQAが付与された合計103件のベンチマークになります。Heron-BenchではLLM-as-a-Judgeで評価を行い、Judgeを行うモデル(Judgeモデル)は、質問、VLM回答、参照文(正解文)、contextの4つの情報からスコアを計算します。

Contextは画像について人手で付与した説明文で、日本の作品名や建物の固有名詞を含みます。参照文はcontextと質問からgpt-4-0125-previewで生成した文で、VLMの回答と比較するための基準として利用されます。(質問、context、生成文)の組を入力として、Judgeモデルにより生成文の良さを1〜10の10段階評価でスコア付けします。(質問、context、参照文)と(質問、context、VLMの回答)それぞれについてスコアを独立に計算した後、(VLM回答によるスコア)/(参照文によるスコア)が最終的なスコアとなります。

本記事の評価でも、提供元の実装をベースとしたLLM-as-a-Judgeによって評価しましたが、以下の点で変更を加えました。

- (★)JudgeモデルにGPT-4o(

gpt-4o-2024-08-06)を使用しました。Heron-BenchのJudgeモデル(gpt-4-0125-preview)では内部で評価した際に試行ごとのスコアの変動が大きく一つの課題となっていましたが、gpt-4o-2024-08-06に置き換えることでスコアの変動を抑えられたため採用しました。

JDocQA3

提供元:https://github.com/mizuumi/JDocQA (ただし、本記事ではllm-jp-eval-mmの方法に倣い、shunk031さんのHuggingFaceリポジトリを利用しました)

官公庁が公開している官報やパンフレット、国立大学のHPで大学へのアクセスを説明する模式図が掲載されているページをPDF化したものなど、日本語の文書にQAが付与されたデータセットです。こちらのtestセットをベンチマークとして用います。JDocQAには以下の4種類の質問タイプが含まれます。

- はい/いいえ形式(Yes/No): 「はい」か「いいえ」で回答する質問

- 事実抽出形式 (Factoid): 本文中から事実を抜き出して回答する質問

- 数量形式 (Numerical): 簡単な四則演算や単位を含めて数字で回答する質問

- 自由記述形式(Open-ended): 他の3種類と異なり、ある程度の長さの文章を作成して回答する質問

本記事の評価ではllm-jp-eval-mmの方法に倣い、自由記述形式に対しては日本語トークナイザによるsacreBLEUのスコアを採用し、他の質問タイプに対しては正解が回答に含まれていれば正解(スコア1.0)として、全体の平均スコアを計算しました。PDFの画像化には、llm-jp-eval-mmと同様pdf2imageを用い、dpiをdpi=200(ベンチマーク中の画像の縦横のピクセル数が1,000-3,500程度)としました。

本記事の評価では、以下の点で変更を加えました。

- (★)全体のうち11件はページ数指定のアノテーションの誤りと思われる問題で画像を取得することができなかったため除外しました。また、回答を導くのに参照する必要のあるページが複数にわたるサンプル(すなわち、複数画像入力のサンプル)10件についてはJMMMUと同様除外して評価しました。結果、全1,176件のうち1,155件を評価対象としました。

複雑図表ベンチマーク

独自に構築した、日本語図表に関する画像理解能力を評価するためのベンチマークです。系統図や路線図、その他イラストを含む図などの複雑な図表画像で構成されます。Heron-Benchと同様の形式にて評価し、評価モデルには本記事でのHeron-Benchと同様にGPT-4o(gpt-4o-2024-08-06)を使用しました。contextだけでなく、参照文もあらかじめ人手により付与されている点がHeron-Benchと異なります。

評価結果

国内の既存の日本語VLMとの比較

まず、Sarashina2-Vision-8B, 14Bと国内で開発されたVLMとの比較を表1に示します。並び順は各ベンチマークにおけるランキングの平均(平均ランク)の高い順としました。Sarashina2-Vision-14BはHeron-Benchでほぼ最上位と同等、JMMMU、JDocQA、複雑図表で最高スコアを達成しており、Sarashina2-Vision-8Bが続いています。Sarashina2-Vision-8B, 14Bは特に図表ドメインであるJDocQAや複雑図表で他のVLMよりもスコアが高いことがわかります。Sarashina2-Vision-14Bは8Bよりも図表の理解能力が伸びている他、JMMMUのスコアも伸びており、日本の文化に関する知識も含めた総合的な日本語VLM能力が伸びていることが期待されます。

表1:国内の日本語VLMとSarashina2-Vision-8B, 14Bの比較(平均ランク順)。ベンチマーク内の最上位スコアを太字、2番目を下線で示します。

| モデル名 | モデルサイズ(B) | Heron-Bench | JMMMU | JDocQA | 複雑図表 | 平均スコア | 平均ランク |

|---|---|---|---|---|---|---|---|

| sbintuitions/Sarashina2-Vision-14B | 14.4 | 0.644 | 0.433 | 0.245 | 1.018 | 0.585 | 1.5 |

| sbintuitions/Sarashina2-Vision-8B | 8.0 | 0.648 | 0.393 | 0.229 | 0.92 | 0.548 | 2.25 |

| AXCXEPT/EZO-InternVL2-26B | 25.5 | 0.609 | 0.389 | 0.196 | 0.882 | 0.519 | 3.75 |

| llm-jp/llm-jp-3-vila-14b | 14.2 | 0.665 | 0.23 | 0.176 | 0.896 | 0.492 | 5.25 |

| AXCXEPT/Llama-3-EZO-VLM-1 | 8.5 | 0.494 | 0.394 | 0.102 | 0.83 | 0.455 | 5.5 |

| SakanaAI/Llama-3-EvoVLM-JP-v2 | 8.5 | 0.509 | 0.389 | 0.103 | 0.779 | 0.445 | 5.5 |

| SakanaAI/EvoVLM-JP-v1-7B | 7.6 | 0.459 | 0.341 | 0.138 | 0.752 | 0.423 | 7 |

| turing-motors/heron-chat-git-ja-stablelm-base-7b-v1 | 7.3 | 0.461 | 0.294 | 0.069 | 0.466 | 0.323 | 10 |

| cyberagent/llava-calm2-siglip | 7.5 | 0.521 | 0.07 | 0.084 | 0.69 | 0.341 | 10.25 |

| MIL-UT/Asagi-4B | 4.2 | 0.443 | 0.278 | 0.089 | 0.365 | 0.294 | 11.25 |

| MIL-UT/Asagi-14B | 14.2 | 0.433 | 0.302 | 0.06 | 0.392 | 0.297 | 11.5 |

| stabilityai/japanese-stable-vlm | 7.6 | 0.374 | 0.096 | 0.103 | 0.502 | 0.269 | 12 |

| toshi456/llava-jp-1.3b-v1.1 | 1.8 | 0.457 | 0.274 | 0.05 | 0.387 | 0.292 | 12.25 |

| weblab-GENIAC/Tanuki-8B-vision | 8.0 | 0.489 | 0.129 | 0.042 | 0.471 | 0.283 | 12.25 |

| MIL-UT/Asagi-8B | 7.8 | 0.436 | 0.259 | 0.045 | 0.392 | 0.283 | 12.75 |

| stabilityai/japanese-instructblip-alpha | 8.2 | 0.341 | 0.255 | 0.072 | 0.352 | 0.255 | 14 |

| MIL-UT/Asagi-2B | 2.3 | 0.418 | 0.127 | 0.032 | 0.346 | 0.231 | 16.5 |

| rinna/bilingual-gpt-neox-4b-minigpt4 | 4.9 | 0.263 | 0.2 | 0.037 | 0.296 | 0.199 | 16.75 |

※LLM-as-a-Judgeによる評価は一回のみ行いました。

海外の既存のオープンVLMとの比較

次に、日本語が生成可能な代表的なオープンVLMとの比較を表2に示します。表1と同様に並び順は平均ランクの高い順としました。

平均ランクでは、Sarashina2-Vision-14Bが1位、Sarashina2-Vision-8Bは4位という結果になりました。JMMMUやJDocQAではQwen2-VL-7B-Instructが依然強力であるものの、Heron-Benchと複雑図表ではSarashina2-Vision-14Bが上回っており、8B〜14B規模のモデルとしては高性能なオープンVLMに肉薄する位置につけています。

表2:海外のオープンVLMとSarashina2-Vision-8B, 14Bとの比較(平均ランク順)。ベンチマーク内の最上位スコアを太字、2番目を下線で示します。

| モデル名 | モデルサイズ(B) | Heron-Bench | JMMMU | JDocQA | 複雑図表 | 平均スコア | 平均ランク |

|---|---|---|---|---|---|---|---|

| sbintuitions/Sarashina2-Vision-14B | 14.4 | 0.644 | 0.433 | 0.245 | 1.018 | 0.585 | 1.75 |

| Qwen/Qwen2-VL-7B-Instruct | 8.3 | 0.619 | 0.462 | 0.282 | 1.001 | 0.591 | 2 |

| OpenGVLab/InternVL2_5-4B | 3.7 | 0.578 | 0.429 | 0.234 | 1.005 | 0.562 | 3 |

| sbintuitions/Sarashina2-Vision-8B | 8.0 | 0.648 | 0.393 | 0.229 | 0.92 | 0.548 | 3.25 |

| Qwen/Qwen2-VL-7B | 8.3 | 0.575 | 0.382 | 0.189 | 0.831 | 0.494 | 5.75 |

| OpenGVLab/InternVL2_5-8B | 8.1 | 0.554 | 0.381 | 0.218 | 0.815 | 0.492 | 6 |

| meta-llama/Llama-3.2-11B-Vision-Instruct | 10.7 | 0.487 | 0.321 | 0.184 | 0.869 | 0.465 | 7.5 |

| Qwen/Qwen2-VL-2B-Instruct | 2.2 | 0.482 | 0.365 | 0.195 | 0.765 | 0.452 | 7.5 |

| OpenGVLab/InternVL2-8B | 8.1 | 0.534 | 0.362 | 0.18 | 0.742 | 0.455 | 8.25 |

| llava-hf:llava-1.5-13b-hf | 13.4 | 0.446 | 0.314 | 0.158 | 0.551 | 0.367 | 10 |

| llava-hf:llava-1.5-7b-hf | 7.1 | 0.404 | 0.221 | 0.12 | 0.442 | 0.297 | 11.25 |

| Qwen/Qwen2-VL-2B | 2.2 | 0.347 | 0.271 | 0.102 | 0.206 | 0.232 | 11.75 |

※評価は一回のみ行いました。

JMMMUの日本文化に関するカテゴリにおける性能比較

Sarashina2-Vision-8B, 14Bの日本文化に対する強みを確認するため、JMMMUのカテゴリの中で、日本の文化に関する3カテゴリ(Japanese_{Art, Heritage, History})に注目しました。以下、これらのカテゴリを日本文化カテゴリと呼ぶことにします。

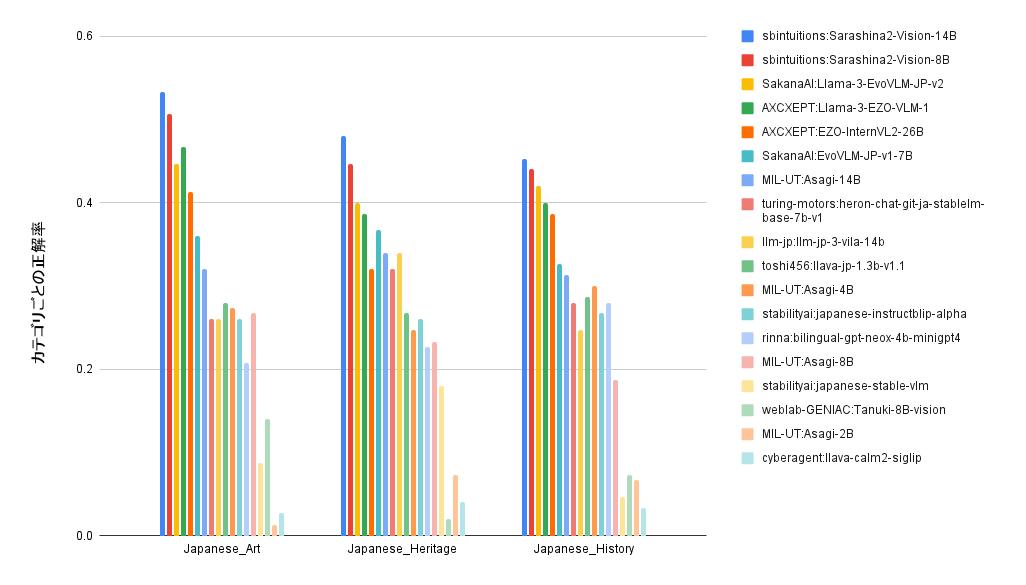

図1は日本文化カテゴリの各カテゴリにおける正解率を既存の国内の日本語VLMとSarashina2-Vision-8B, 14Bの間で比較したものになります。Sarashina2-Vision-8B, 14Bは、他の日本語VLMよりも高い正解率を達成しており、日本の芸術作品や文化遺産、歴史といった、日本の文化に関するVQAにより強みがあると言えます。

図1:JMMMUの日本文化カテゴリにおける正解率(日本語VLM vs Sarashina2-Vision、左から日本文化カテゴリのスコアの平均が高い順)

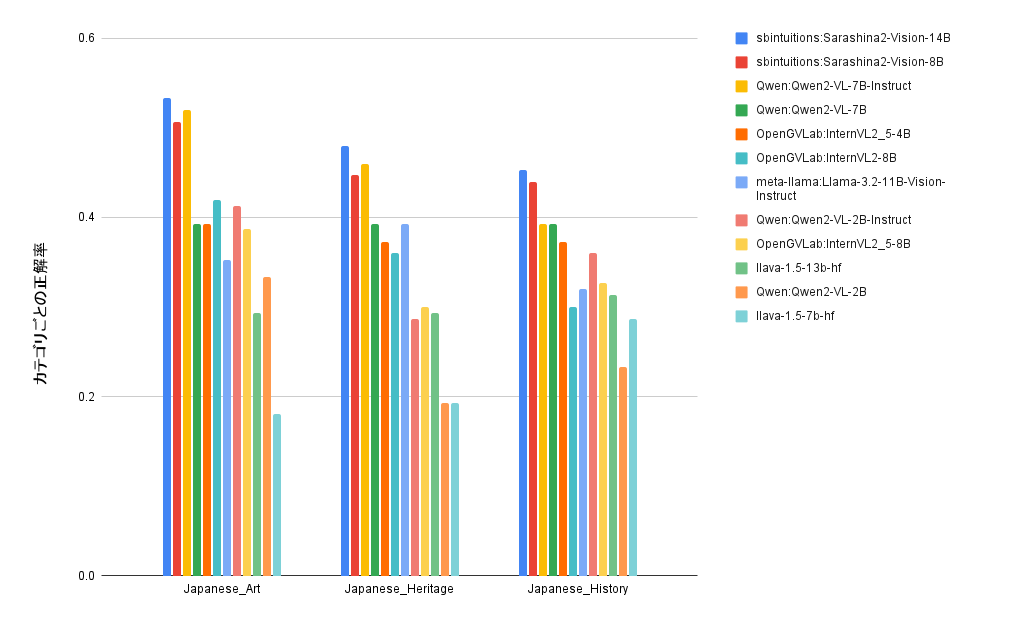

同様に、日本文化カテゴリにおける正解率を海外の既存のオープンVLMと比較した結果を図2に示します。日本文化カテゴリにおいては、Sarashina2-Vision-8B, 14BがともにQwen2-VL-7B-Instructと同等ないしは上回って最上位につけており、日本の文化の知識・理解の面で上回っていることが考えられます。この部分は日本語でスクラッチから事前学習をしているSarashina2の特徴がSarashina2-Visionにおいてもうまく引き継がれていることを示しています。

図2:JMMMUの日本文化カテゴリにおける正解率(海外のオープンVLM vs Sarashina2-Vision、左から日本文化カテゴリのスコアの平均が高い順)

Sarashina2-Visionの生成結果の例

実際にSarashina2-Visionが生成した例を紹介します。

日本の風景の認識

神奈川県の横浜が撮影された以下の画像を用います。

入力したプロンプトとSarashina2-Vision-8B/14Bの回答です。

| 入力 | 写真に写っている建物から、この写真はどこで撮影されたと考えられるか、教えてもらえますか? |

|---|---|

| 8B回答 | 写真に写っている建物から、この写真は横浜で撮影されたと考えられます。横浜は、高層ビルや観覧車などの現代的な建築物と、川や運河などの水辺の風景が共存する都市として知られています。写真に写っている建物も、横浜のランドマークタワーや観覧車などの有名な建物と似ています。 |

| 14B回答 | この写真は、横浜のみなとみらい地区で撮影された可能性が高いです。みなとみらい地区は、横浜港に面したエリアで、高層ビルや観覧車などの観光スポットが数多くあります。写真に写っている建物は、横浜ランドマークタワーやクイーンズスクエア横浜などのみなとみらい地区にある建物と似ています。また、写真に写っている川は、横浜港に流れ込む大岡川である可能性があります。 |

いずれのモデルも的確な回答をしています。回答にはそれぞれ特徴がありますが、日本の土地や建物に関する知識を正しく答えています。特に、Sarashina2-Vision-14Bの回答はより細かな粒度で写真の場所や建物の情報に言及しています。

日本の風景と一般物体認識

2つ目の例では、オフィスビルから撮影された以下の画像を用います。

| 入力 | この写真に写っているもので、最も有名と考えられる建築物は何でどこに写っていますか? |

|---|---|

| 8B回答 | この写真に写っているもので、最も有名と考えられる建築物は東京タワーです。東京タワーは、東京のランドマークであり、この写真では、ビル群の向こうに写っています。 |

| 14B回答 | この写真に写っているもので、最も有名と考えられる建築物は東京タワーです。東京タワーは、東京の街並みの右側に写っています。 |

いずれのモデルも東京タワーを指しており、その写っている位置も正しく回答しています。

この写真には、東京タワーと似た赤と白の配色、かつ大きさ形状ともに目立って見えるクレーンも写っています。上の結果だけではクレーンを東京タワーと誤認した可能性を排除できません。そこで、正しく真ん中のクレーンとその右にある東京タワーを別々に認識できているか確かめました。

| 入力 | 真ん中に映っている赤と白の物は何ですか? |

|---|---|

| 8B回答 | 真ん中に映っている赤と白のものはクレーンです。 |

| 14B回答 | 赤と白の物はクレーンです。 |

どちらのモデルも中央の物体をクレーンと答えており、東京タワーとクレーンを正しく認識できていることが確認できました。

図の読み取り

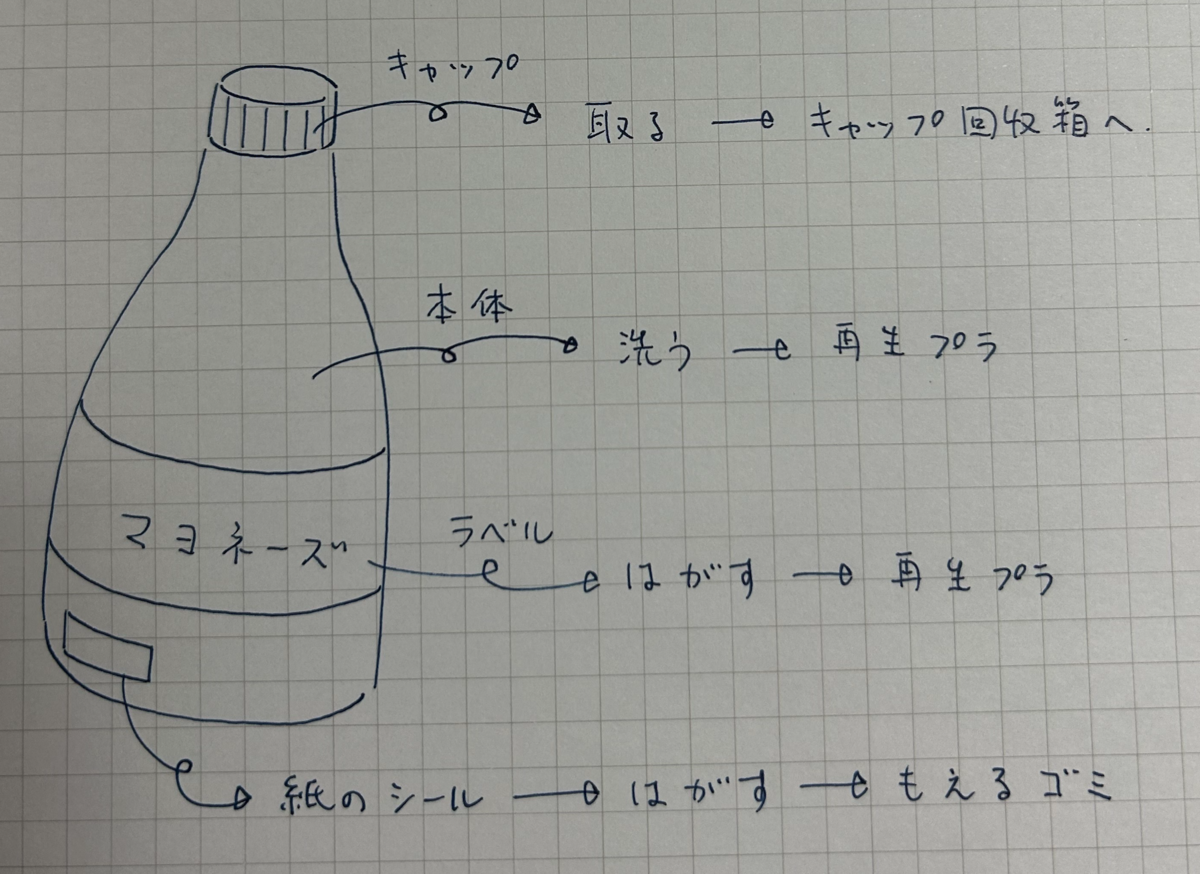

最後の例では、図から情報を読み取り人が理解しやすく回答できるかどうかを確認しました。ゴミ捨ての手順を描いた以下の画像を用います。

| 入力 | ゴミの分別方法を教えてくれますか? |

|---|---|

| 8B回答 | はい、ゴミの分別方法を教えます。まず、ペットボトルのキャップとラベルを剥がし、キャップは回収箱へ、ラベルは燃えるゴミとして出します。次に、ペットボトルの本体を洗い、再利用プラスチックとして出します。最後に、紙のシールを剥がし、燃えるゴミとして出します。 |

| 14B回答 | もちろんです!この画像では、マヨネーズのボトルを例に、ゴミの分別方法を説明します。まず、マヨネーズのボトルは、キャップ、本体、ラベル、紙のシールの4つの部分に分けられます。キャップは、キャップ回収箱へ捨てます。本体は、洗って、再生プラとして捨てます。ラベルは、はがして、再生プラとして捨てます。紙のシールは、はがして、燃えるゴミとして捨てます。このように、ゴミを分別することで、資源の再利用や環境保護に貢献することができます。 |

いずれのモデルも図と質問の意図を理解できていると思われます。Sarashina2-Vision-8Bの結果は間違い(ペットボトルと言ってしまったり、ラベルを燃えるゴミとしている)も含みますが、Sarashina2-Vision-14Bでは、内容の正確さと日本語の自然さともに違和感のない結果が得られました。

生成結果の観察から得られた知見

このように、日本文化や図表ドメインに対するSarashina2-Visionの強みを定性的にも確認できました。検討すべき事項は多く残されていますが、例えばモデルサイズによる更なる改善の余地も期待されます。

おわりに

本記事では、日本文化や図表ドメインに対するSarashina2-Visionの強みを定量的、定性的に確認しました。 一方で、今回のモデルにはまだまだ改善点は多く、正しく質問に答えられない場合や画像中に存在しない物事に関する記述をする例も多々見受けられました。また、JDocQAやJMMMUの日本文化以外のカテゴリなどでは上位のモデルに及ばない結果となっており、改善の余地が多く残されています。 SB Intuitionsでは引き続きVLMの性能改善を目指してモデル開発を継続していきます。 本記事がVLM構築や評価において、皆様のお役に立てば幸いです。

プロジェクトメンバー

- 鈴木哲平: 学習コードの実装・内製ベンチマークの構築・プロジェクトリード

- 品川政太朗: VLMの評価基盤の構築・内製ベンチマークの構築・評価を実施

- 小澤圭右: VLMの評価基盤の構築・評価を実施

- 田中稔之: VLMの事前学習・学習コードの実装・学習データの合成を実施

- 髙田拓実: 事後学習におけるデータセットの検証とVLMの訓練を実施

- 臼井久生: 学習データの作成・整形を実施

- 大島遼祐: VLMの評価基盤の構築・評価を実施

- 今井悠人: VLMの評価基盤の構築・評価を実施

- JMMMU: A Japanese Massive Multi-discipline Multimodal Understanding Benchmark for Culture-aware Evaluation (NAACL2025)↩

- Heron-Bench: A Benchmark for Evaluating Vision Language Models in Japanese (CVPR2024 workshop, Computer Vision in the Wild (CVinW))↩

- JDocQA: 図表を含む日本語文書質問応答データセットによる大規模言語モデルチューニング (NLP2024), JDocQA: Japanese Document Question Answering Dataset for Generative Language Models (LREC-COLING 2024)↩